robots.txt

概要

robots.txtに必要事項を記載することで、Googlebotのような検索エンジンクローラーに対して、ディレクトリやページへのクロールを制御することができます。

※デフォルトでは全てのページで全てのクローラーをブロックする記述になっています。

※テスト環境、本番環境のサイトドメイン、サイトファイル、独自ドメインに対しても適用されます。

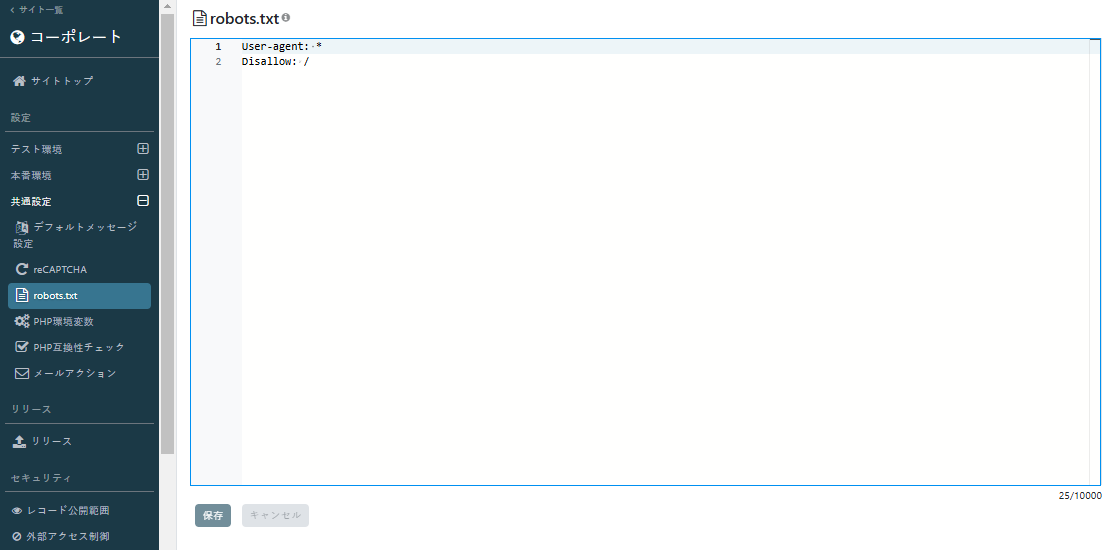

操作画面

サイト管理の左メニュー「共通設定>robots.txt」から設定します。

記入例

全てのページで全クローラーをブロック

User-agent: *

Disallow: /

全てのページで全クローラーを許可

User-agent: *

Allow: /

aaaとbbbいうディレクトリ配下のページで全クローラーをブロック

User-agent: *

Disallow: /aaa/

Disallow: /bbb/

全てのページでGooglebotをブロック

User-agent: Googlebot

Disallow: /

cccのディレクトリ配下のみGooglebotのクロールを許可

User-agent: Googlebot

Allow: /ccc/※ こちらの記載例は一例です。その他robots.txtの記述方法についてはインターネットにてお調べください。

robots.txtの適用確認

「共通設定>robots.txt」で設定した内容は、以下のURLにアクセスして確認できます。

https://サイトドメイン/robots.txt